August 2025

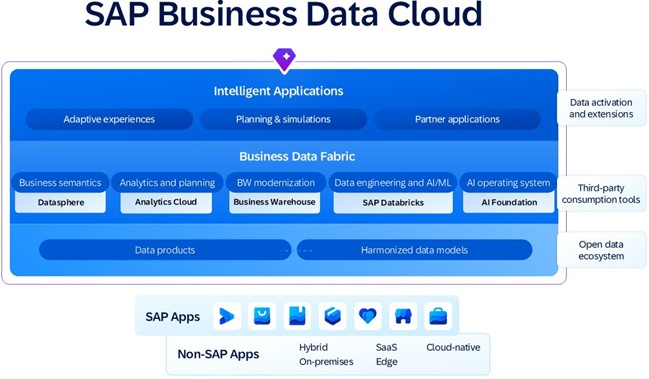

Kurze Einführung und Überblick

Quelle: https://www.sap.com/products/data-cloud.html

In diesem Blog zeigen wir, wie sich durch die Kombination der drei Produkte SAP-Daten mit den Ergebnissen eines benutzerdefinierten Machine-Learning-Modells bündeln und visualisieren lassen.

Ich stelle ein Szenario zur Prognose der Speiseeis-Nachfrage vor, bei dem tatsächliche Transaktionsdaten mit einer Wettervorhersage kombiniert werden, die durch ein benutzerdefiniertes Predictive-Modell erzeugt wurde.

Der aktuelle Blogbeitrag soll keine komplexen Fälle aus dem Bereich maschinelles Lernen oder Best Practices für die Datasphere-Modellierung vorstellen, sondern vielmehr zeigen, wie die Interaktion zwischen den Produkten aussieht und wie sie sich gegenseitig ergänzen. Der hier beschriebene Geschäftsfall ist vereinfacht dargestellt; dasselbe Konzept kann jedoch auf beliebig komplexe Szenarien angewendet werden – beispielsweise auf die Analyse des Kundenverhaltens, die Erstellung personalisierter Chatbots, die Optimierung der Bestandsverwaltung, die Analyse von Social-Media-Kampagnen und vieles mehr.

In diesem Blog werde ich beschreiben, wie man:

- in Databricks ein lineares Regressionsmodell für Wettervorhersagen erstellt,

- die vorhergesagten Ergebnisse mit Datasphere teilt,

- in Datasphere ein analytisches Modell erstellt, das Transaktionsdaten mit den von Databricks erhaltenen Vorhersagen kombiniert, und

- das analytische Modell in der SAP Analytics Cloud nutzt, um eine Nachfrageprognose zu erstellen.

Bevor wir loslegen, möchte ich darauf hinweisen, dass ich keinen BDC-Tenant verwende. Datasphere und SAC werden erst ab dem 1. Januar 2026 innerhalb von BDC verfügbar sein, weshalb ich ursprünglich vorhatte, die BDC-Testversion zu nutzen. Leider war mein Test-Tenant jedoch so eingeschränkt, dass ich keine benutzerdefinierten Data Products erstellen und diese mit Databricks teilen konnte. Auch das Erstellen benutzerdefinierter Notebooks in Databricks war nicht möglich.

Meine Datasphere- und Databricks-Mandanten befinden sich in separaten Clouds und sind über JDBC miteinander verbunden. BDC wiederum verwendet das Delta Share-Protokoll, um Daten zwischen Anwendungen auszutauschen.

Dennoch sollten wir bedenken, dass Datenprodukte im Wesentlichen Datensätze sind, und der einzige Unterschied zwischen diesem Blog und dem BDC-Mandanten das Datenaustauschprotokoll ist.

Inhalt

Business Szenario

Technische Umsetzung

- Überblick Datenmodell

- Modell mit linearer Regression in Databricks erstellen

- Modellierung in Datasphere

- Visualisierung in SAC

Zusammenfassung

Business Szenario

Technische Umsetzung

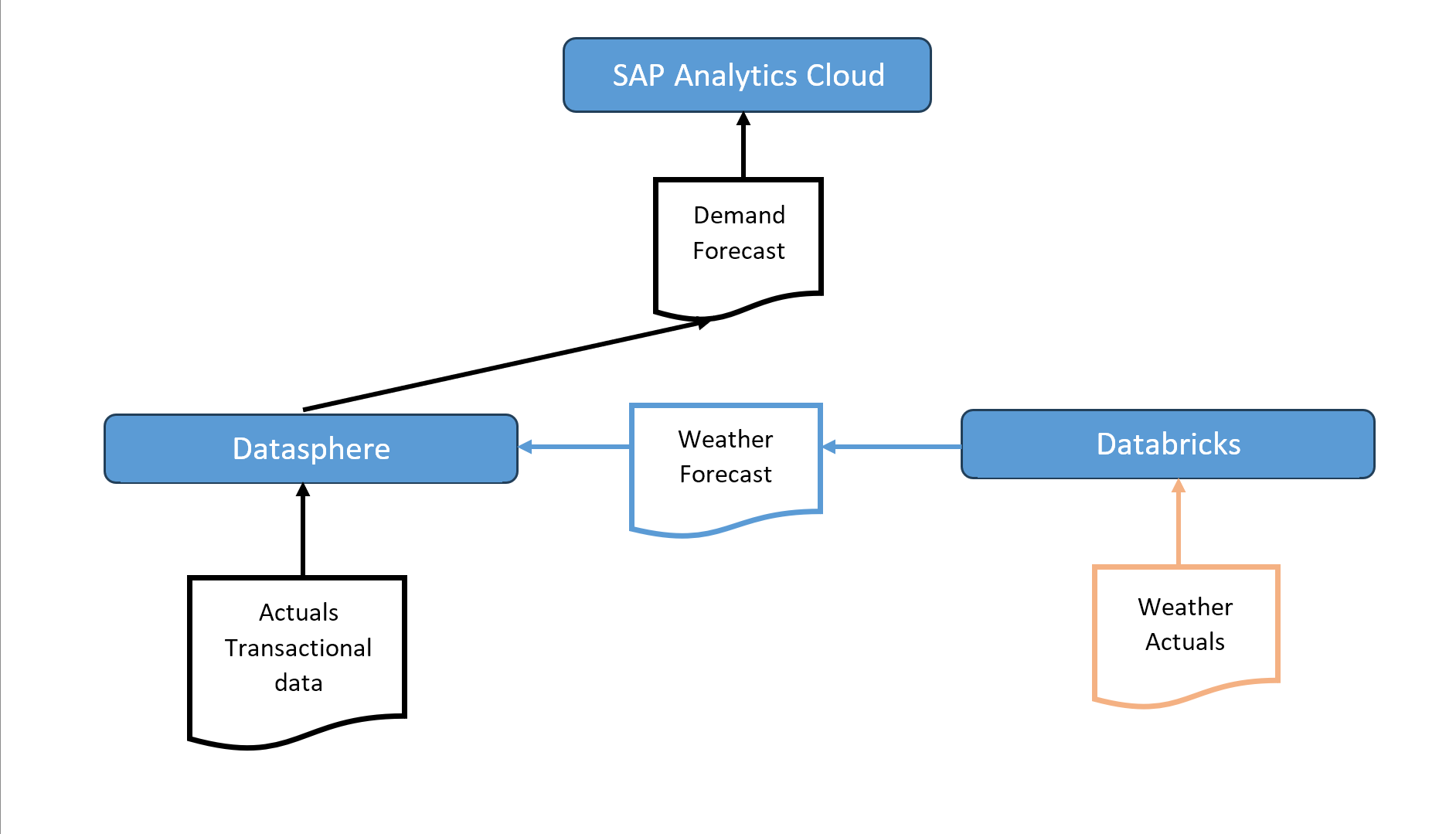

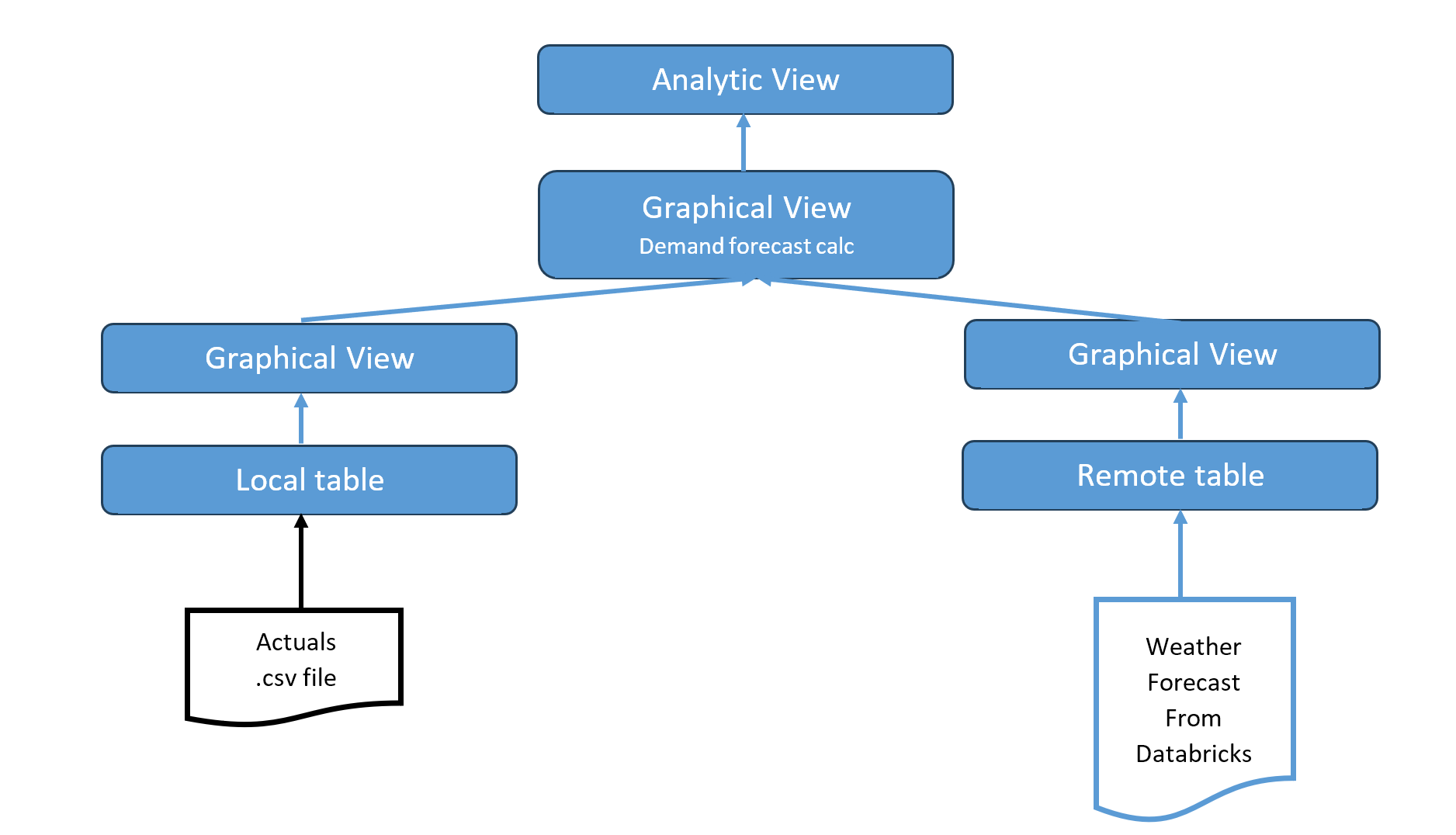

Überblick Datenmodell

Die Ist-Daten werden über eine CSV-Datei in Datasphere geladen. Diese sind ein Datenprodukt im BDC-Tenant. Diese Daten können z. B. aus einem S/4HANA-Cloud-System kommen.

Die historischen Daten für das Wetter werden in Databricks direkt von Zenodo.org gelesen (in einem echten System kann dies jeder andere Wetterdienst sein).

Databricks verwendet die historischen Wetterdaten als Trainingsdatensatz für das KI-Modell. Nachdem das Modell trainiert ist, wird eine Wettervorhersage für den nächsten Monat erstellt. Diese Vorhersage wird dann nach Datasphere übertragen, für die weitere Modellierung und Berechnung.

Datasphere erhält die Wettervorhersage von Databricks und berechnet den Forecast für den Eisverkauf auf Basis des Ist-Verkaufs des Vorjahres.

Der so erzeugte Forecast im analytischen Modell von Datasphere wird dann als Datenquelle für die SAC-Story verwendet.

Der komplette Datenfluss ist in folgendem Bild dargestellt:

Modell mit linearer Regression in Databricks erstellen

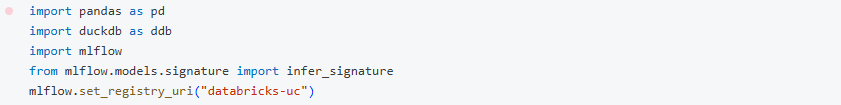

Im Folgenden ist das Python-Skript dargestellt, das ich für die Modellierung der Wettervorhersage mit einer linearen Regression erstellt habe.

Installiere die benötigten Libraries:

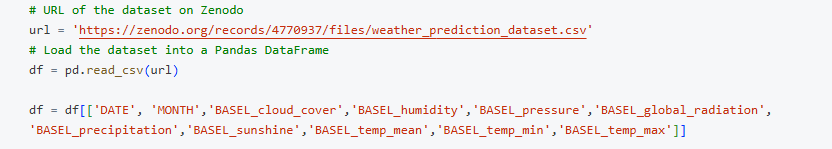

Lade den Datensatz in ein Pandas Data Frame. Ich verwende nur die Region Basel.

Der Datensatz kommt von: https://zenodo.org/records/4770937/files/weather_prediction_dataset.csv

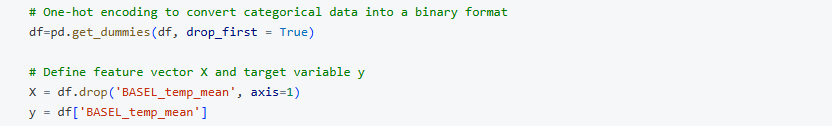

Durchführen einer Konvertierung und Definition des Merkmals – Vektors mit den Ziel – Variablen

Definition der Trainings – und Testdaten und trainieren des Models

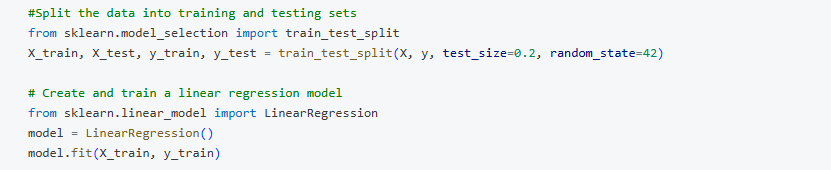

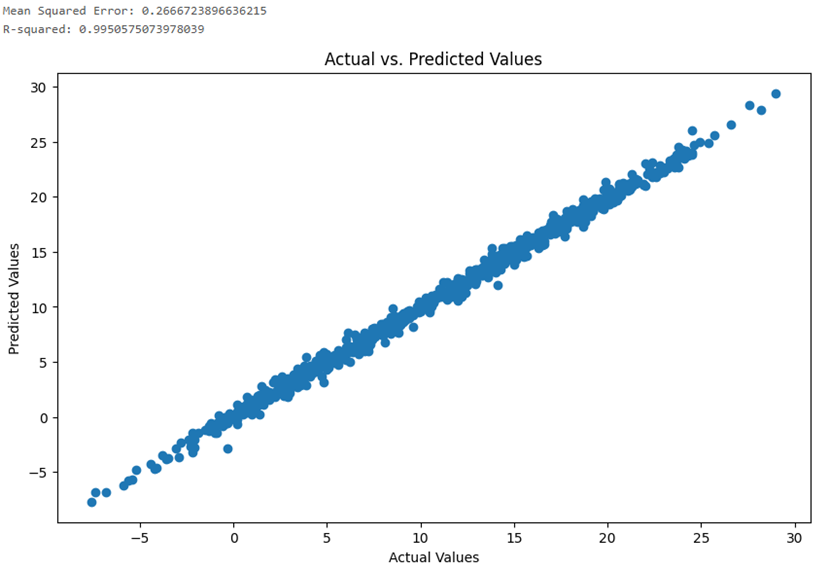

Überprüfen des Modells mit der mittleren quadratischen Abweichung und des Residuenquadrats

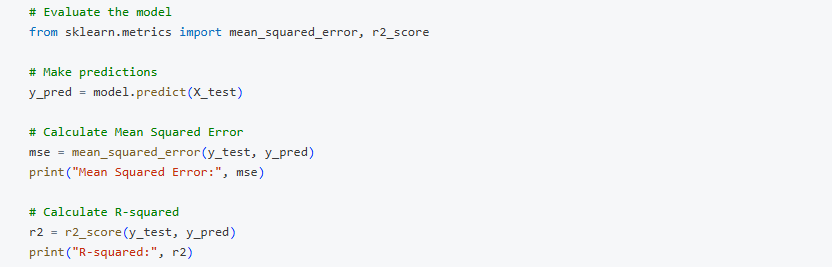

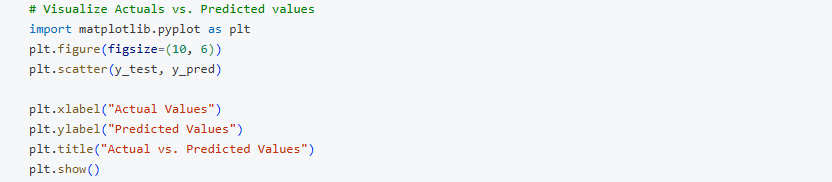

Darstellung der Genauigkeit des Modells

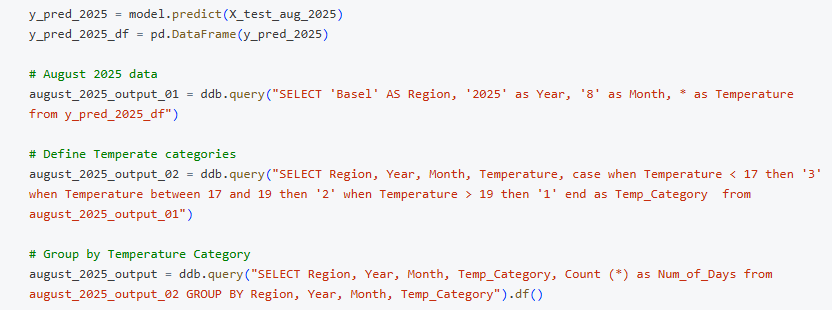

Nun ist das vortrainierte Modell bereit, die Temperaturen für August 2025 vorherzusagen..

„X_test_aug_2025“ enthält den Merkmalsvektor;

„y_pred_2025“ – vorhergesagte Temperatur;

„August_2025_output“ Tabelle mit der Anzahl Tage in jeder Kategorie

Definition der Kategorieen:

„Cold“ – Kleiner als 17° C;

„Warm“ – zwischen 17° C und 19° C;

„Hot“ – Größer als 20° C.

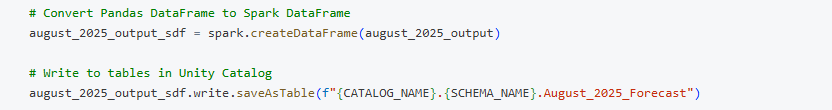

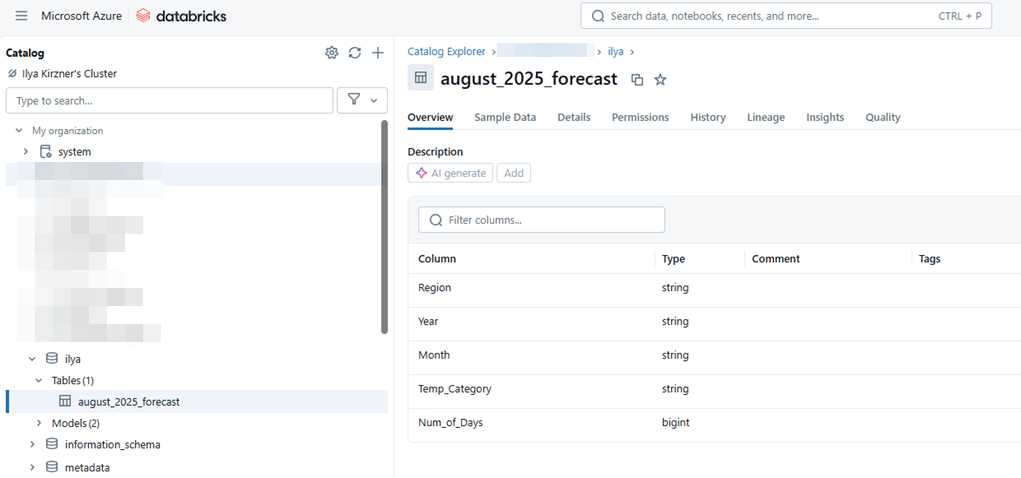

Jetzt erfolgt noch die Formatierung von Pandas- nach Spark-Datenrahmen und das Speichern der Tabelle im Unity Catalog.

Die endgültige Tabelle „August_2025_Forecast“ enthält die Spalten Region, Jahr, Monat, Temperaturkategorie und die erwartete Anzahl von Tagen pro Temperaturkategorie.

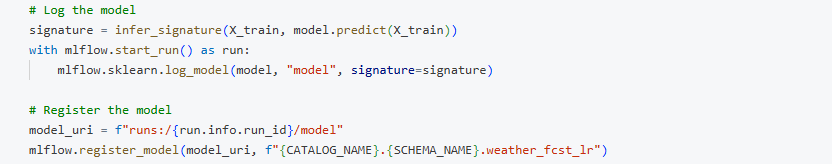

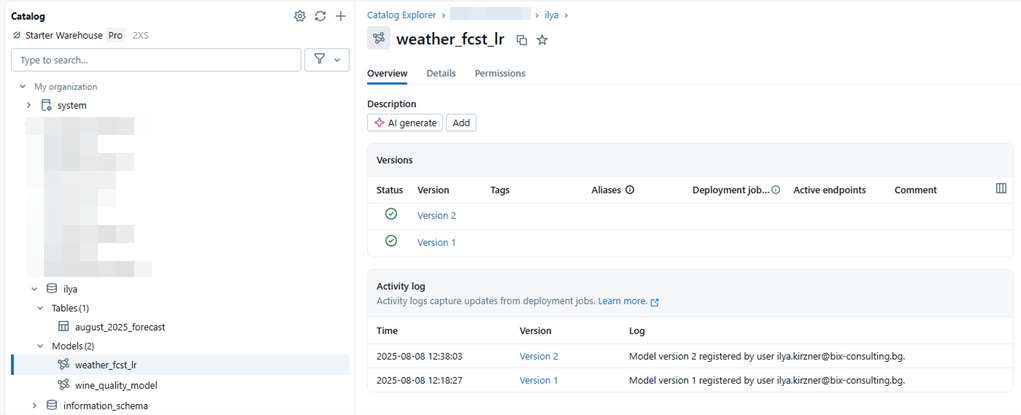

Log und registriere das Modell, um es weiter verwenden zu können.

Das Modell “weather_fcst_lr” ist nun im Unitiy – Katalog gesichert.

Modellierung in Datasphere

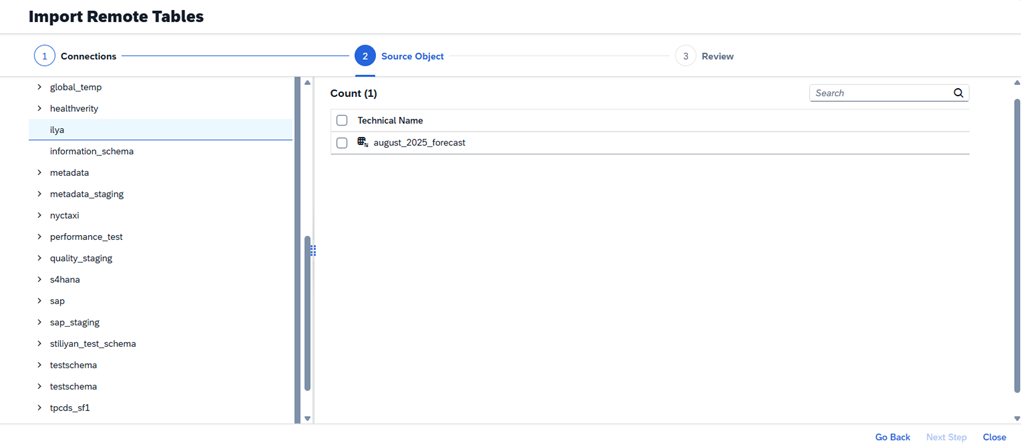

Als nächsten Schritt wollen wir die Wettervorhersage aus Databricks nach Datasphere übertragen und dies mit den transaktionalen Ist-Daten verknüpfen.

Das Datasphere Datenmodel:

Die generierte Wettervorhersage wird aus Databricks über einen Remote-Tabellenzugriff in Datasphere über eine generische JDBC-Verbindung zur Verfügung gestellt.

In diesem Blog werden die Schritte erklärt, wie eine JDBC – Verbindung zwischen Datasphere und Databricks aufgebaut wird.

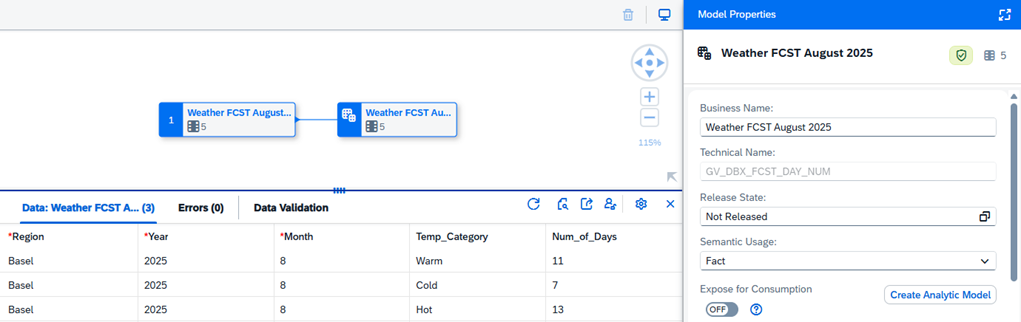

Ein graphischer View „GV_DBX_FCST_DAY_NUM“ basiert auf der Remote – Tabelle:

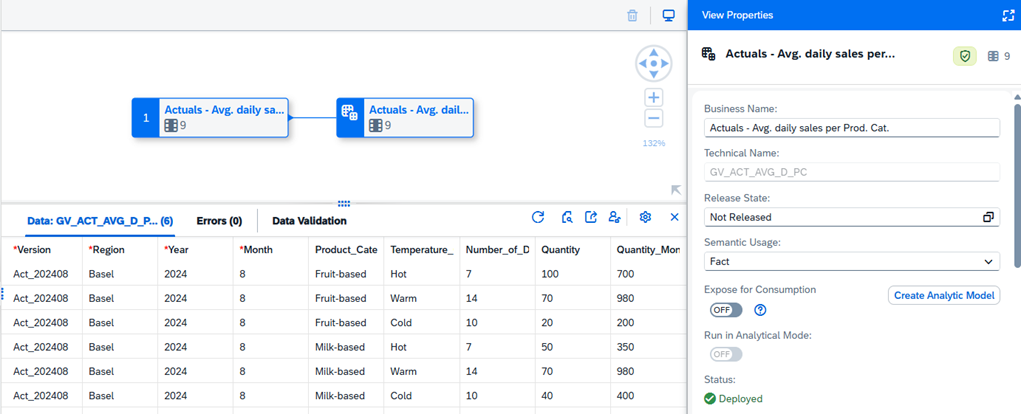

Der graphische View „GV_ACT_AVG_D_PC“ basiert auf der lokalen Tabelle, die die durchschnittlichen täglichen Verkaufsmengen aus dem letzten Jahr je Produktkategorie enthält. Im unteren Bereich ist die Datenvorschau zu sehen.

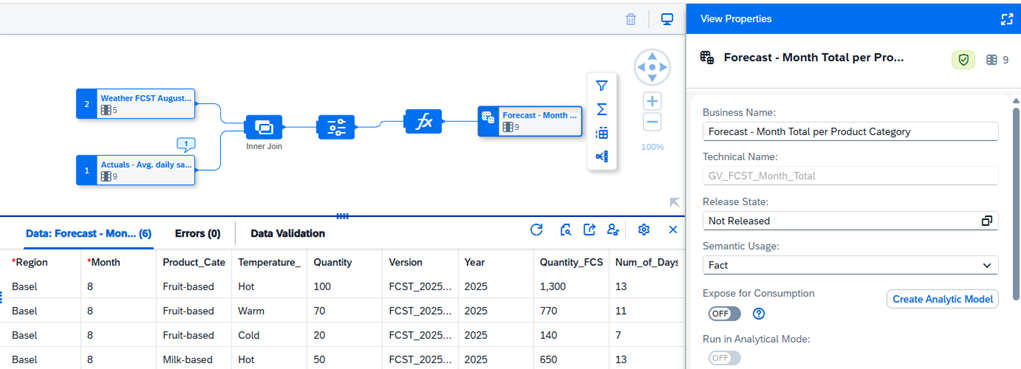

Der graphische View „GV_FCST_QUANT“ enthält die Berechnung für den Forecast des nächsten Monats („Quantity_FCST“).

Die durchschnittliche Verkaufsmenge je Produkt- und Temperaturkategorie aus August 2024 wird mit den erwarteten Tagen der entsprechenden Temperaturkategorie multipliziert, um den Forecast zu erhalten.

Die Ist-Werte des Vorjahres werden mit der Prognose für das aktuelle Jahr in der Ansicht „GV_FCST_Month_Total“ kombiniert.

In der Datenvorschau unten sehen Sie die Spalte „Quantity“, die die tatsächlichen täglichen Verkaufsmengen darstellt, die auch für die Prognoseberechnung des aktuellen Jahres herangezogen werden. Die Spalte „Quantity_FCST“, berechnet als „Quantity“* „Number of days“, stellt die monatliche Mengenprognose für das aktuelle Jahr dar. Es ist wichtig, die Kennzahlen in der Ansicht auszugeben.

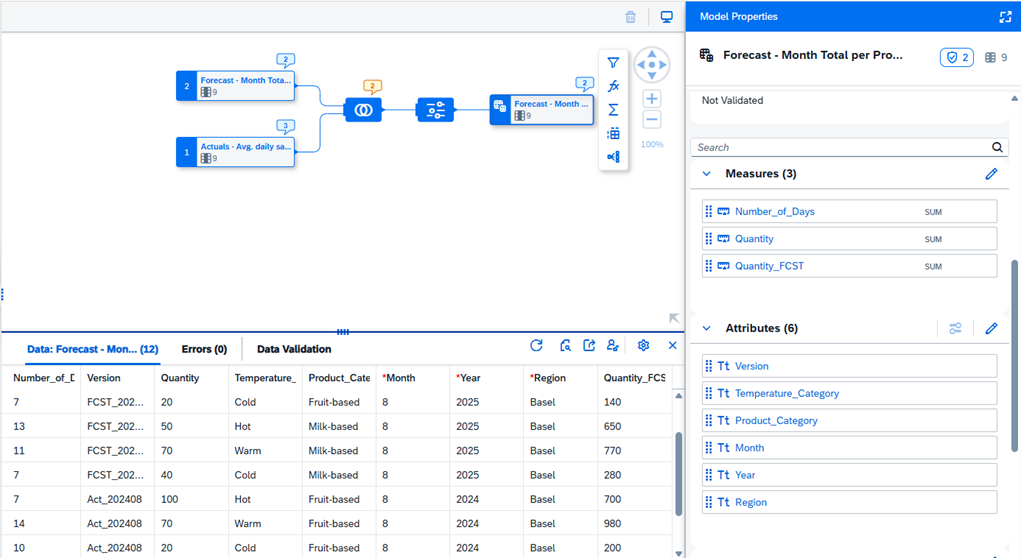

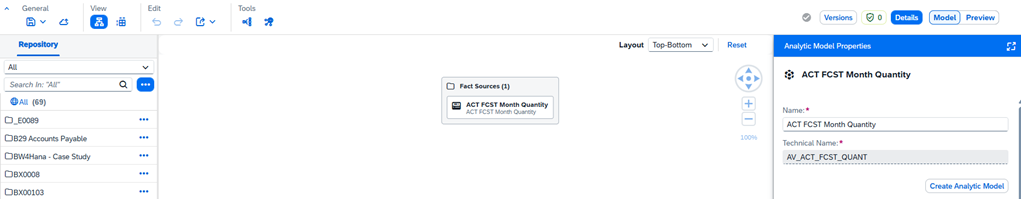

Das analytische Modell „AV_ACT_FCST_QUANT“ wird auf der Grundlage der grafischen Ansicht „GV_FCST_Month_Total“ für die weitere Verwendung in SAC erstellt:

Darstellung in der SAC

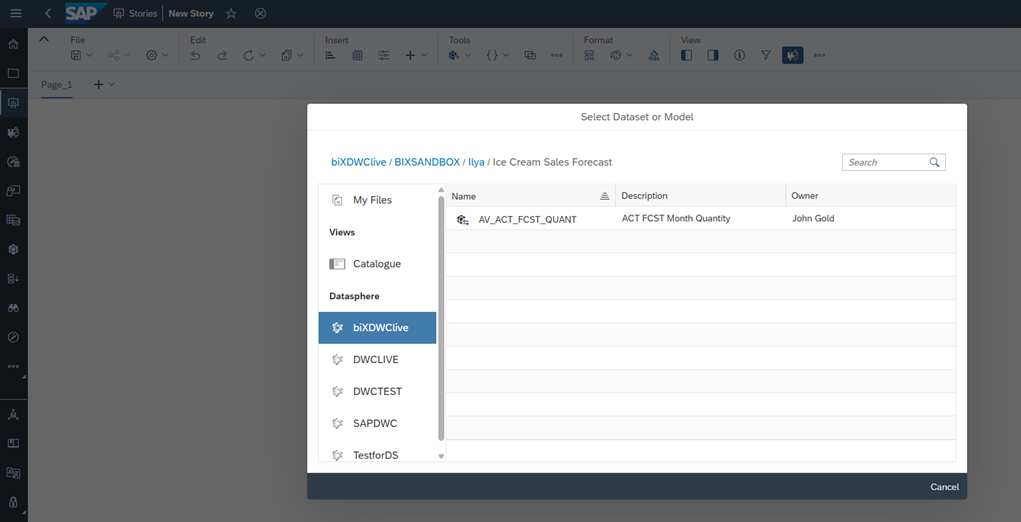

Das analytische Modell „AM_ACT_FCST_QUANT“ wird in der SAC-Story direkt als Datenquelle verwendet. Das Modell ist über die SAC-Datasphere-Verbindung verfügbar:

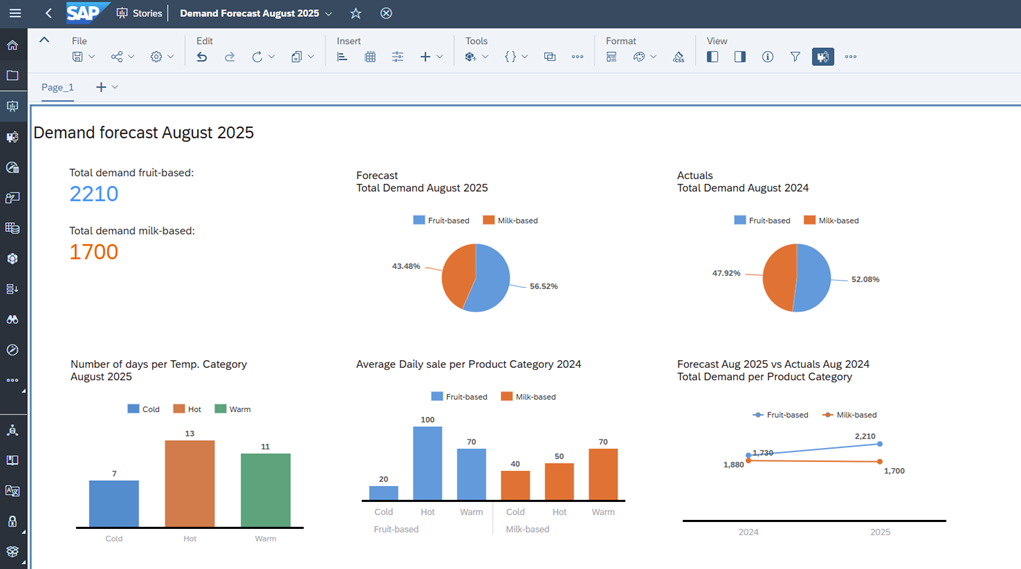

Die folgende SAC-Story basiert auf dem analytischen Modell und visualisiert:

- die Gesamtnachfrage pro Produktkategorie,

- die Anzahl der Tage pro Temperaturkategorie,

- den durchschnittlichen Tagesumsatz des Vorjahres pro Produktkategorie,

- den Vergleich zwischen Prognose und Ist-Zahlen.

Zusammenfassung

In diesem Blog habe ich gezeigt, wie SAP Datasphere, SAP Analytics Cloud und Databricks zusammenarbeiten und es ermöglichen, Unternehmensdaten mit den Ergebnissen eines KI-Modells zu bündeln. Auch wenn der Anwendungsfall vereinfacht dargestellt ist, lässt sich dasselbe Konzept in Fällen beliebiger Komplexität anwenden, beispielsweise bei der Analyse des Kundenverhaltens, der Erstellung personalisierter Chatbots, der Optimierung der Bestandsverwaltung, der Analyse von Social-Media-Kampagnen und vielem mehr.

Ich habe gezeigt, wie man:

- ein lineares Regressionsmodell in Databricks für Wettervorhersagen erstellt;

- die vorhergesagten Ergebnisse mit Datasphere teilt;

- ein analytisches Modell in Datasphere erstellt, das Transaktionsdaten und die von Databricks erhaltenen Prognosen kombiniert;

- das analytische Modell in SAC nutzt und eine Nachfrageprognose visualisiert.

Bleiben Sie dran für weitere Artikel über Business Data Cloud, Databricks und Business-KI, in denen es darum geht, wie diese Anwendungen die Art und Weise verändern, wie wir mit Unternehmensdaten umgehen!

Wenn Sie mehr über SAP Business Data Cloud erfahren möchten, könnte Sie das Webinar zu diesem Thema interessieren, das vom biX Consulting-Team vorbereitet wurde: https://www.bix-consulting.com/en/sap-business-data-cloud/