August 2025 / Update November 2025

Einführung

Einrichten des Uploads

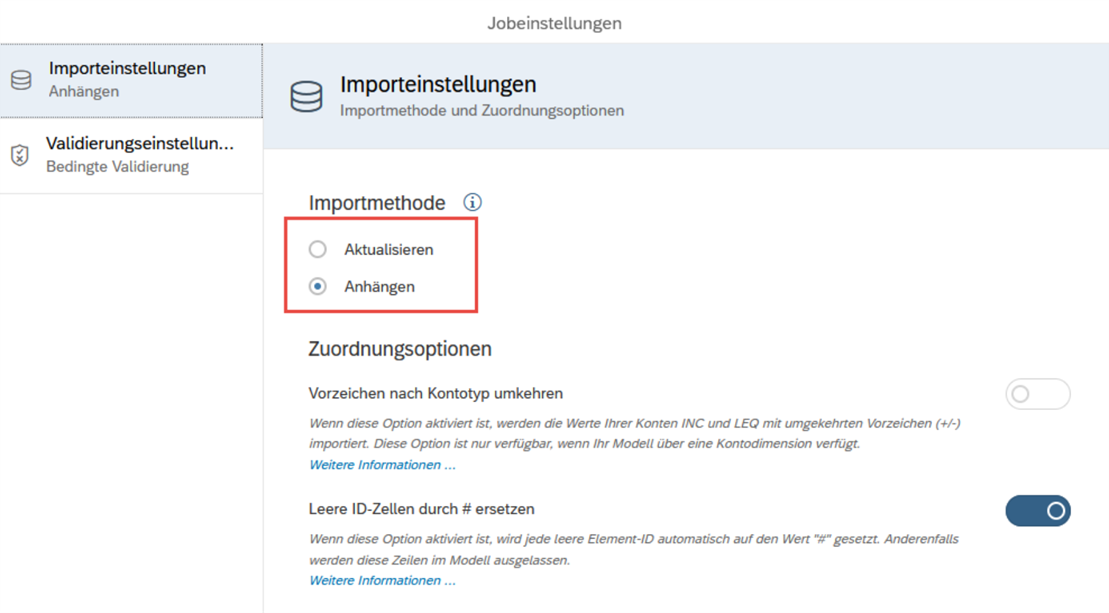

Im ersten Schritt richtet der Administrator oder Modellierer den Upload-Job in der datenverwaltung ein. Hier muss ein Template-File (.csv/ xlsx und .txt sind unterstützt) hochgeladen werden, wobei gegebenenfalls nötige Transformationen definiert werden können. Im letzten Schritt ordnet man die Spalten des Files den Dimensionen des Modells zu. In den Job-Einstellungen wird zusätzlich festgelegt, ob der Import als Update/Aktualisieren oder als Anfügen/Anhängen erfolgen soll und ob das Vorzeichen nach Kontotyp gedreht werden soll.

Abbildung 1: Jobeinstellungen Import Job

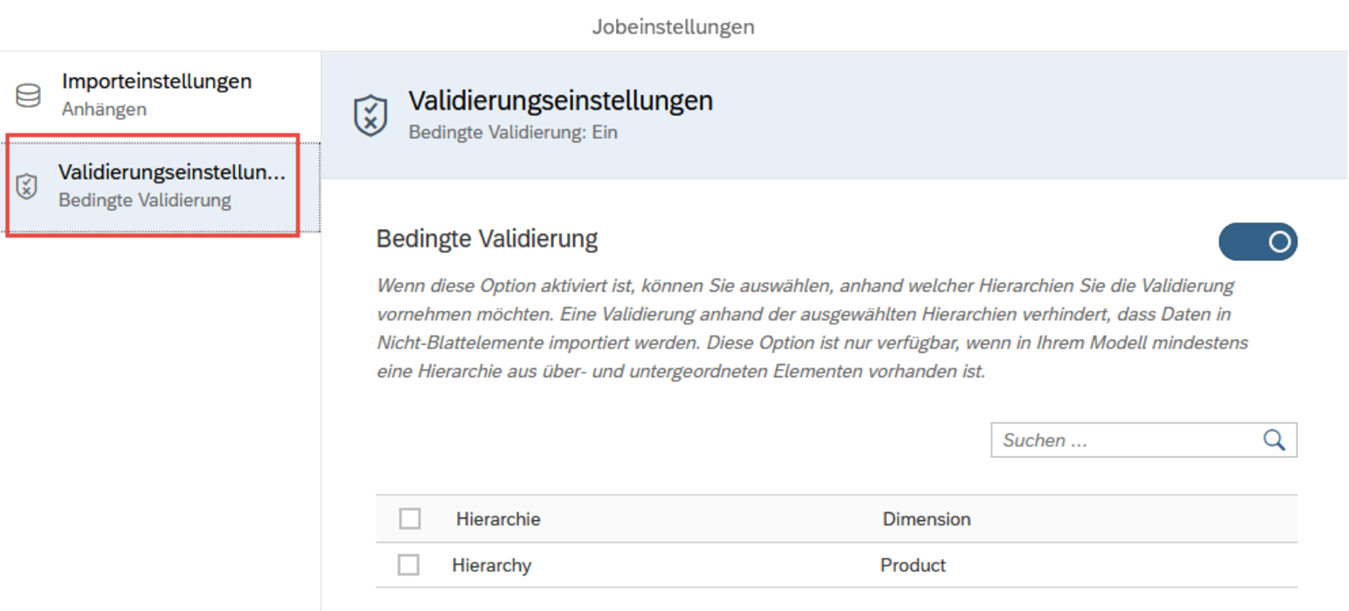

Seit dem Q3/2025-Release kann man hier auch einstellen, ob und nach welcher Hierarchie sichergestellt werden soll, dass nur Daten für Blätter und keine Knoten geladen werden.

Abbildung 2: Jobeinstellungen Import Job – Validierung

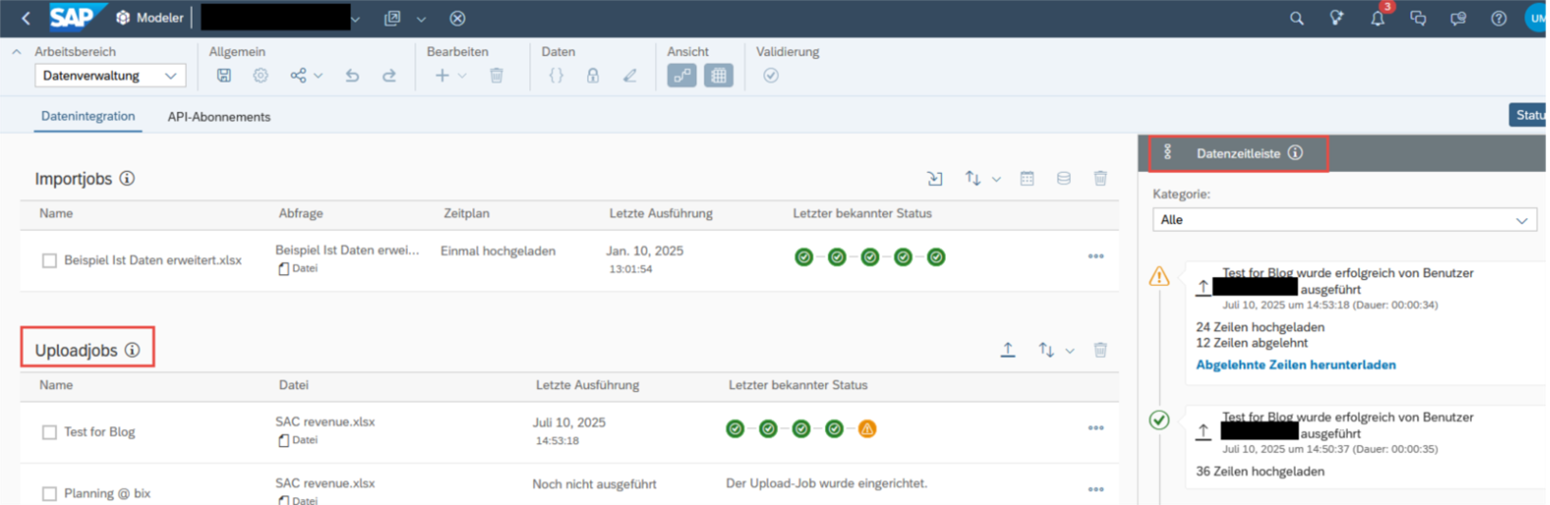

In der Datenzeitleiste der Datenverwaltung sieht man alle durchgeführten Ladejobs, auch die eines Planungs–Users und kann hier erneut den Bericht der abgelehnten Zeilen laden.

Abbildung 3: Neue Option für die Definition von Upload Jobs in der Datenverwaltung mit demn Potokollen in der Datenzeitleiste

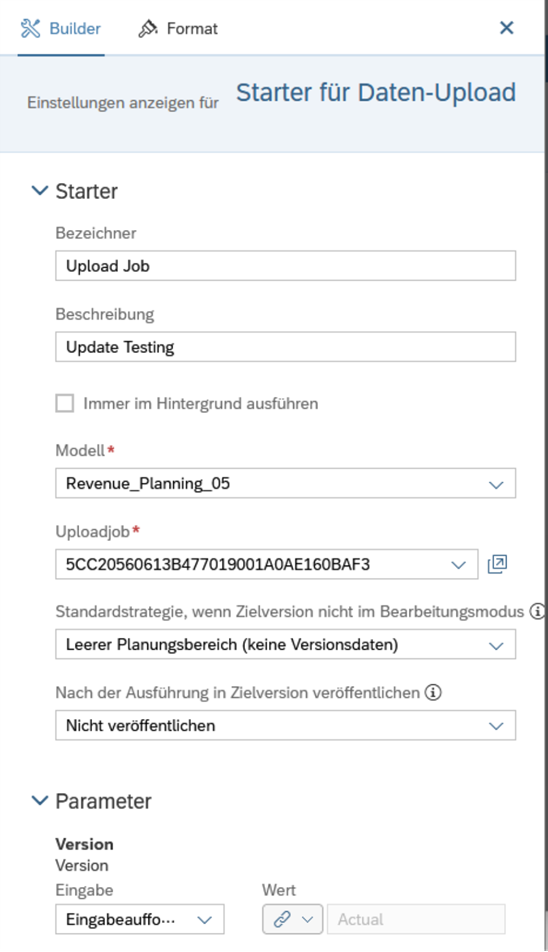

Wenn der Upload–Job angelegt ist, muss der Story Designer einen „Starter für Upload“–Button in die Story einfügen. Der Button funktioniert ähnlich wie ein Data–Action–Widget für konsistente Benutzer–Erfahrung. Beim Konfigurieren der Story muss für diesen Starter zuerst das Modell ausgewählt und anschließend der zuvor angelegte Upload–Job selektiert werden. Ebenso kann festlegt werden, wie die Zielversion bestimmt wird und ob die Daten automatisch veröffentlicht werden sollen oder nicht. Diese Optionen können entweder fest vorgegeben oder über ein Prompt den User bei der Ausführung bestimmen lassen. Wenn Planungsbereiche bei großem Datenvolumen verwendet werden, kann das Verhalten beim Upload weiter spezifiziert werden. Ist alles eingerichtet, ist die Story bereit für einen Daten-Upload.

Abbildung 4: Einstellungen für den Datenupload Starter

Upload Prozess

Skript – Optionen

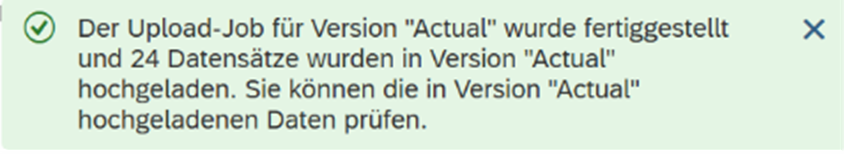

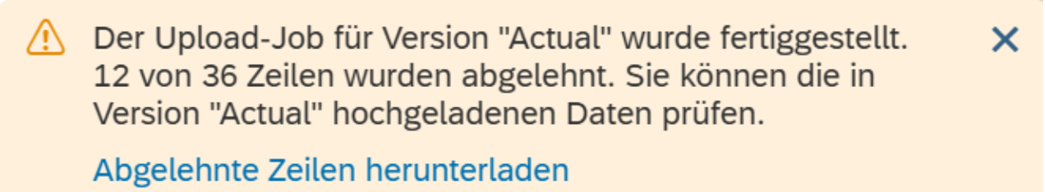

Beim Upload-Job gibt es zwei Zeitpunkte, bei denen man per Skript eingreifen kann: onBeforeExecute und onAfterExecute. Das onBeforeExecute Skript wird ausgeführt, bevor der Upload Bildschirm erscheint, das onAfterExecute Skript läuft, nachdem der Ladeprozess beendet ist.

Als Entwickler ist es wichtig zu beachten, dass die Skripte auch ausgeführt werden, wenn der Anwender den Prozess im Popup abbricht oder wenn die Daten nur teilweise geladen werden oder der Upload komplett fehlschlägt. Um sicherzustellen, dass die Befehle nur ausgeführt werden, wenn der Prozess vollständig erfolgreich war, kann man folgendes Coding in der onAfterExecute-Methode verwenden (oder natürlich den Status Warnung bzw. Fehler entsprechend abfragen):

|

if (status === DataUploadExecutionResponseStatus.Success ) { …; } |

Dieser Status ist im Event onBeforeExecute nicht bekannt! Achten Sie daher darauf, dass Änderungen aus dem onBeforeExecute-Skript wieder rückgängig gemacht werden, wenn der Anwender den Vorgang abbricht oder es Probleme mit abgelehnten Zeilen gab.

Leider steht die Information zu den Ablehnungen nicht im Skript zur Verfügung.

Release Q3/2025

Bessere Fehlerbearbeitung

Die Fehlerbearbeitung ist umständlich. Es wäre wünschenswert, fehlerhafte Zeilen direkt in einem Popup-Fenster korrigieren zu können:

Beispiel für die File-Struktur

Kein Laden von Stammdaten möglich

Nur feste Spalten im File möglich

Daten löschen während des Ladeprozesses

Bessere Verarbeitung von fehlenden Daten im File im „Aktualisieren“ Fall, wie oben schon erwähnt:

Data Upload Starter Clean/Replace and Clean/Replace Subset not available

Dies ist für das Release Q4/2025 geplant:

Plan Entry: clean and replace for data file upload

Update Nov. 2025: Diese Funktionalität wurde wie angekündigt zur Verfügung gestellt (Details s. oben)!